Vers une architecture automatique?

L’ordinateur qui remporte un concours d’architecture, ce n’est plus impensable. Quatre exemples de processus de conception automatisés issus de la recherche.

Depuis peu de temps, les joueurs de go sont définitivement vaincus par l’intelligence artificielle dans les compétitions officielles. Qu’en est-il des architectes, qui sont régulièrement mis en compétition ? L’ordinateur sera-t-il dans un futur proche capable de faire le travail de l’architecte ? Une équipe de chercheurs de l’EPFZ, baptisée Kaisersrot, s’est sérieusement posé la question il y a plus de dix ans. En exploitant les technologies digitales, ils ont tenté d’élaborer un automate complet capable de reproduire les phases de conception d’un projet, du volume aux façades, et sont allés jusqu’à entrer en lice dans des concours d’architecture1. « Le test de Turing a été passé »2, pouvait-on entendre murmurer dans les couloirs de la chaire de design digital : en observant certains résultats, il est en effet difficile de déterminer à première vue si l’auteur est humain ou non. En revanche, le mode de conception diffère. Comme l’explique Philipp Dohmen, à l’époque chercheur dans cet institut, la machine ne peut pas résoudre un problème de la même manière qu’un humain. « Les hommes, en principe, travaillent de manière top-down, afin d’aborder des problèmes complexes comme un projet d’architecture. Ils pensent un problème global avant de le diviser, de le ‹ casser ›3 en structures toujours plus petites, jusqu’aux composants de la construction, ceci afin de respecter une cohérence d’ensemble. Les machines, du moins jusqu’à récemment, font exactement l’inverse. Elles sont très mauvaises pour penser de manière globale, structurelle. En revanche, elles sont très fortes pour les opérations répétitives : l’intérêt de la machine réside d’abord dans l’automatisation. »

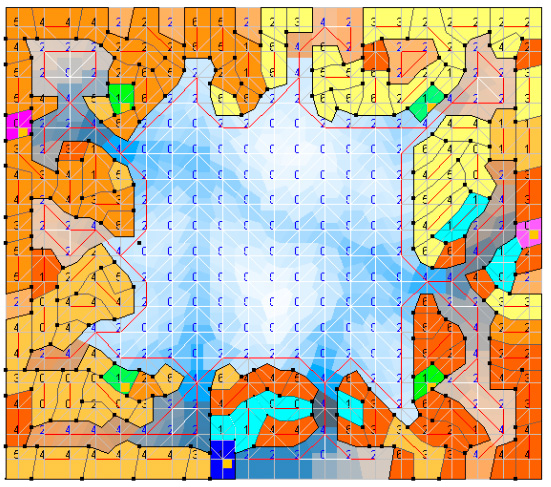

L’ordinateur pittoresque

Chercheur en informatique, Markus Braach, s’est inspiré à la fin des années 1990 des algorithmes évolutifs – des principes qui régissent les systèmes auto--organisés, que l’on peut observer dans la physique, la biologie ou la sociologie. Il a appliqué cette stratégie évolutive pour optimiser des structures urbaines en définissant quelques paramètres topologiques à différentes parcelles occupées : leur taille, les rapports de contiguïté, la hauteur de gabarit, etc. Quand l’informaticien arrive à l’EPFZ, ses préoccupations sur la stratégie bottom-up rencontrent celles de Kees Christiaanse (KCAP). Celui-ci enseigne alors une méthode de planification partant des exigences et des attentes des utilisateurs, et non des décisions du planificateur. Ensemble, ils développent un algorithme pour concevoir un quartier résidentiel à Shuytgraaf aux Pays-Bas, permettant de doter chaque parcelle d’une surface identique et d’optimiser les cheminements tout en répondant aux règlements et aux demandes des futurs habitants (figure de couverture).

Les images qui en sont ressorties, explique Philipp Dohmen, ne ressemblent pas à ce que l’on aurait pu attendre d’une machine, c’est-à-dire des surfaces simples et disposées sur une trame orthogonale. Bien au contraire, cela ressemblait plutôt à la structure d’une ville médiévale vue d’avion, avec des cheminements logiques et « naturels ». La machine peut donc aisément concevoir des processus qui évoquent l’architecture sans architecte, à partir de quelques règles simples qu’un planificateur aurait mis des jours à organiser.

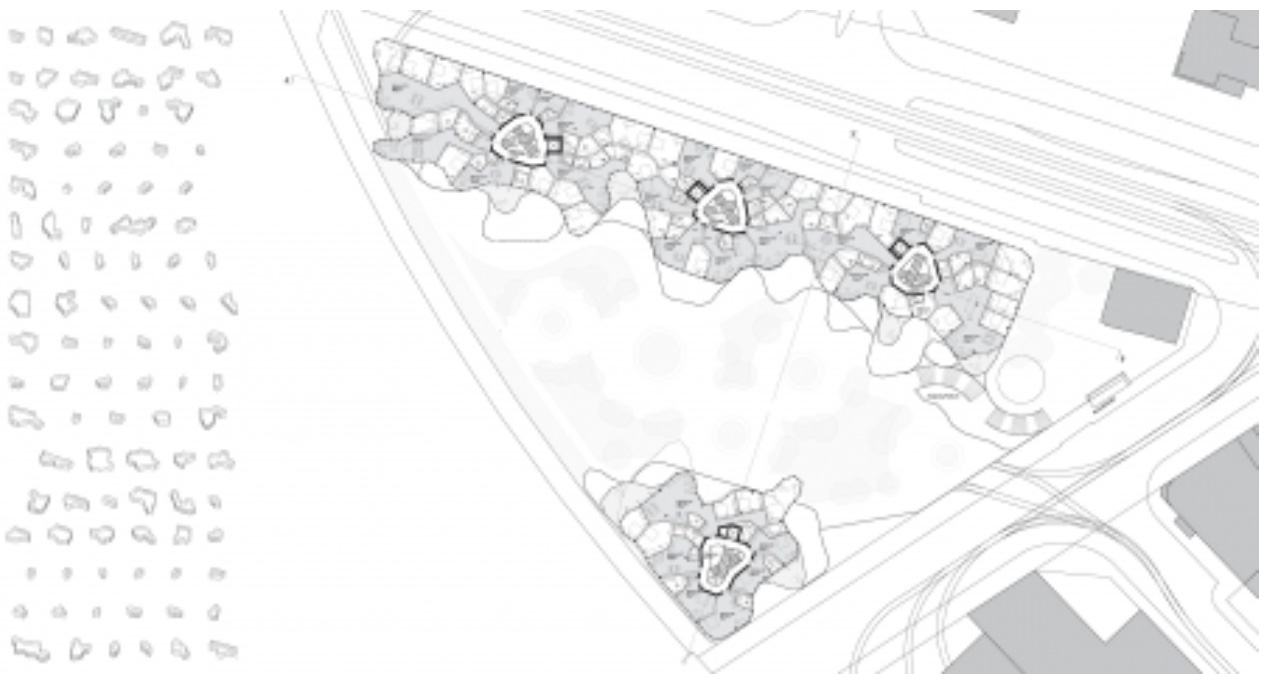

Dans leurs années expérimentales, les associés de group8 ont sollicité l’équipe de Kaisersrot pour les accompagner dans un mandat d’étude parallèle portant sur le plateau d’Ambilly (figure). Avec les informaticiens, ils définissent quelques paramètres, relatifs à l’ensoleillement, à la densité désirée, à la distance aux transports publics, aux relations aux espaces extérieurs et enfin à l’alignement sur le périmètre de l’aire d’intervention. Une fois ces règles décrites dans le protocole, les architectes voient défiler sur l’écran une infinité de variantes : le croisement de toutes les possibilités calculées par l’algorithme. Le projet qui se constitue sous leurs yeux est un organisme informe, croissant. La difficulté, comme l’explique Adrien Besson (group8), était donc d’arrêter ce processus évolutif, de choisir une forme figée dans ce qui ressemble à un processus jamais complètement abouti.

Afin de donner une identité architecturale à un projet qui devait « déjouer la forme pour la forme », ils proposent de l’appeler Urban Picturesque, renouant ainsi avec une catégorie esthétique bien établie, et comparent le projet à une ville italienne médiévale, dont le tissu a été constitué historiquement par quelques règles. Adrien Besson porte a posteriori un regard critique sur l’expérience, aussi instructive fût-elle. « On pourrait tout paramétrer, mais il est toujours plus concluant aujourd’hui de faire du brainstorming autour des maquettes… Car à la fin, il faudra bien choisir. Et ça, l’ordinateur ne le peut pas. »

L’anecdote ouvre une réflexion intéressante sur l’attrait récurrent du mythe de l’autorégulation, trop facilement assimilée à une certaine idée de la nature, sensée s’organiser d’elle-même. En confiant à la machine le soin de générer les formes urbaines, l’architecte informatisé ne risque-t-il pas de perdre encore un peu plus de son autorité ? « Nous ne nous sommes jamais intéressés aux architectes, rétorque Markus Braach, seulement à l’architecture. » Les méthodes de Kaisersrot ont l’ambition de générer de nouveaux concepts, de nouveaux outils, que les architectes pourront s’approprier ou non.

L’architecte automatique

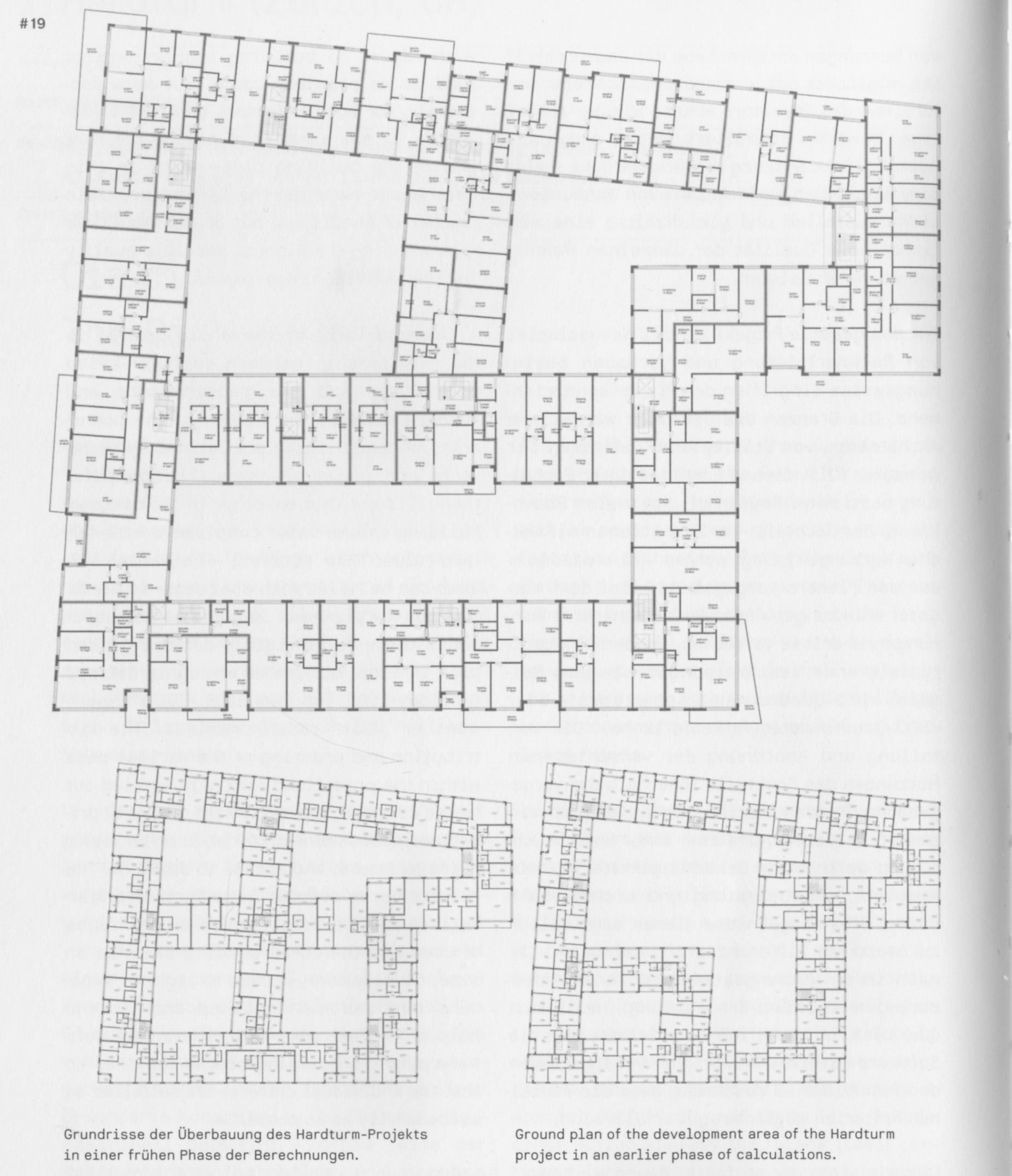

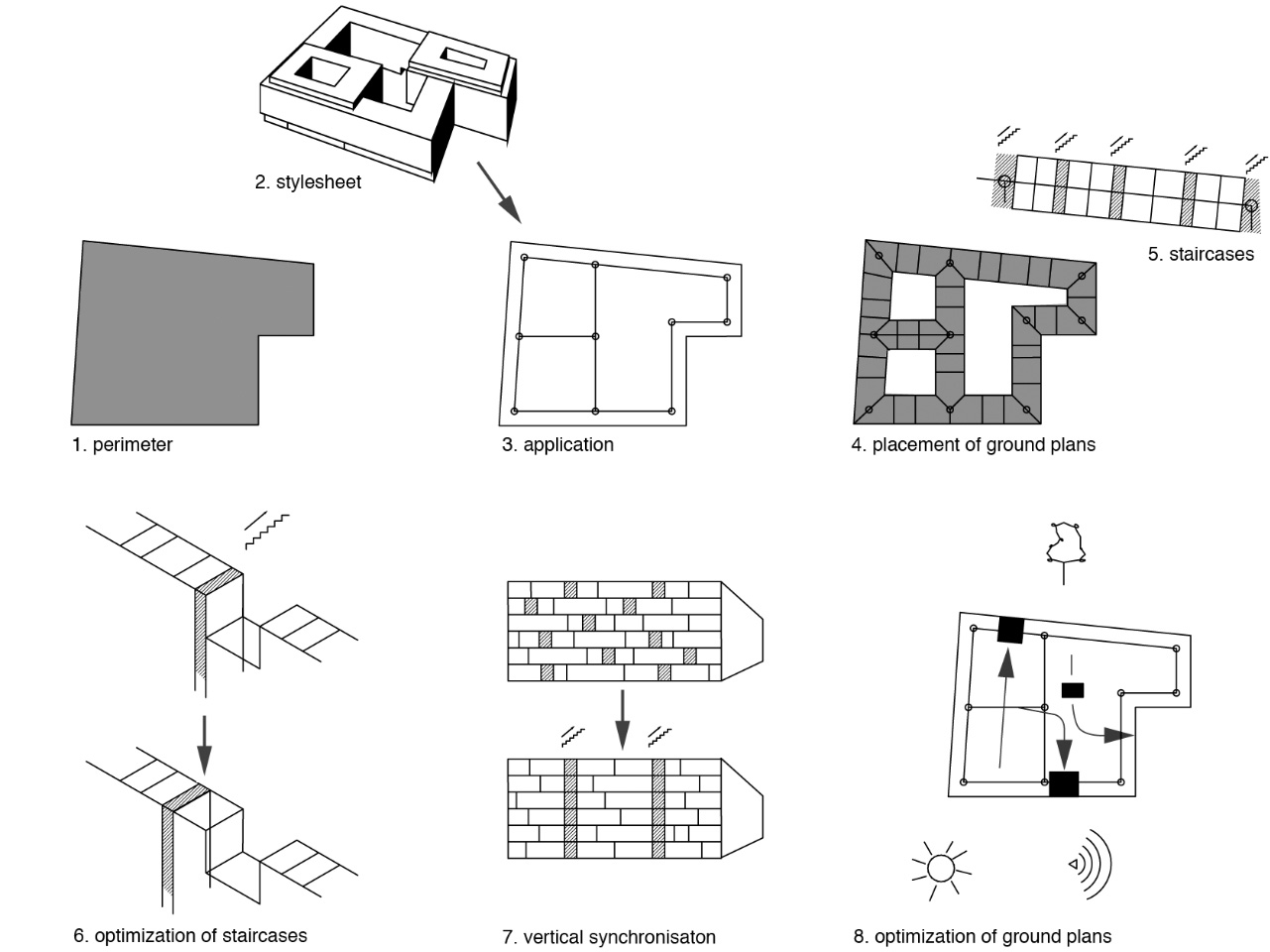

En 2007, l’équipe de chercheurs de la chaire de design digital est parvenue à faire une proposition complète pour une phase d’étude portant sur un ensemble d’habitation de 300 logements. Pour la première fois, des algorithmes étaient utilisés pour le développement complet d’un bâtiment réel. Le processus se déroule en quelques phases qui semblent littéralement simuler les opérations menées par un architecte humain, dans l’exercice de conception de ce type d’objets, de la découpe de volumes en polystyrène, jusqu’à la résolution des façades (figure). Premièrement, la volumétrie est déterminée de manière statistique, en comparant toutes les variantes possibles à l’intérieur du périmètre. Chaque variante est complétée d’une fiche qui donne une première appréciation des appartements, leur nombre, une estimation des coûts, la circulation dans l’immeuble, etc.

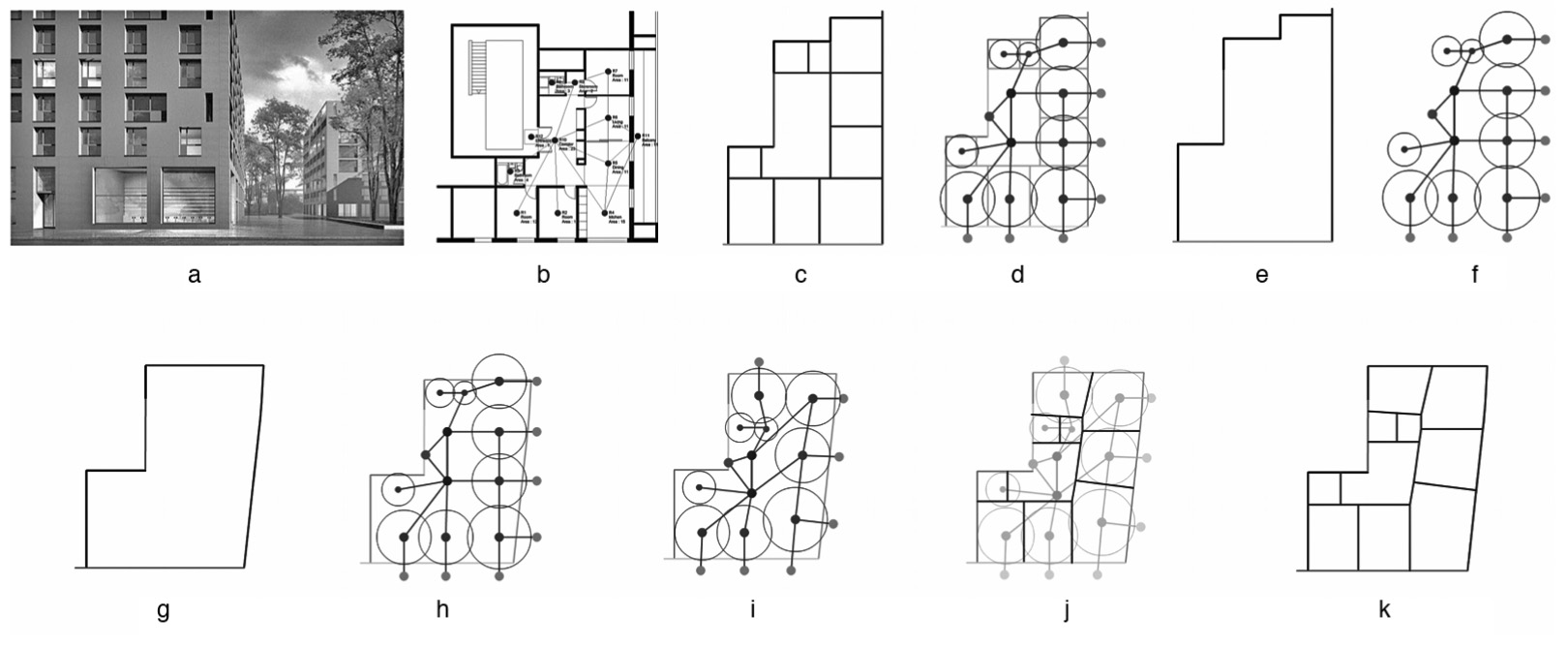

La seconde phase est assez ironique : en supposant que tout a déjà été inventé en termes de typologies d’appartements, les informaticiens collectent simplement les plans d’appartements de 2.5, 3.5 et 4.5 pièces couramment utilisés dans la région zurichoise. Ceux-ci sont ensuite traduits dans un langage informatique qui les décrit en termes géométriques (périmètre, surfaces) et topologiques (interdépendance entre les pièces), indique les conditions d’accès (position de la porte d’entrée) et calcule l’apport en lumière naturelle. Avec ces paramètres, chaque typologie peut être automatiquement adaptée morphologiquement à n’importe quelle situation du plan d’étage (figure). Dans les étapes suivantes, les circulations verticales sont insérées, puis les plans d’étage optimisés de manière à positionner correctement les entrées de l’immeuble. Enfin, la façade est générée automatiquement, à partir de différentes options stylistiques pré-paramétrées. Toutes ces phases de conception sont « enchaînées » les unes aux autres, si bien qu’un changement dans l’une des étapes affectera toutes les autres.

Si les auteurs concluent que « le travail de projétation n’est pas uniquement un acte de création plus ou moins génial », mais qu’il peut également être conçu comme un processus dynamique ouvert, ils prennent tout de même soin de répondre à l’angoisse générée par leur recherche : « il est nécessaire de souligner que le programme, pris individuellement, n’est pas en compétition avec un architecte ou ses compétences et donc qu’il ne génère pas d’architecture, il met seulement à disposition un outil représentant une avancée technologique qui complète la pratique. »4

Les limites de la machine

Les membres disséminés de l’équipe de chercheurs tentent individuellement de poursuivre ces expériences dans des projets réels, hors du terrain privilégié de la recherche académique – ce qui est évidemment bien plus difficile. C’est avec un sourire que Steffen Lemmerzahl raconte avoir utilisé la méthode pour participer au concours pour la coopérative Kalkbreite à Zurich (2007) (figure). Les plans étriqués, produits par des règles paramétriques devant donner des conditions d’ensoleillement optimales à chaque habitant, n’ont pas convaincu le jury. Par la suite, son agence a été mandatée par une de ces grandes firmes qui colonisent le très dynamique Ouest zurichois pour réaliser un immeuble de bureau. En faisant jouer les algorithmes, il parvient rapidement à trouver la solution qui optimise l’apport de lumière pour chaque espace de travail. L’application de ces outils est donc bien limitée, reconnaît Steffen Lemmerzahl. Ces méthodes sont utilisées exclusivement dans le contexte ultra--compétitif d’entreprises qui cherchent le moyen d’optimiser au maximum leurs surfaces, sur un terrain qui a pris une valeur extrême. Et dans ce cas, l’outil informatique accompagne un long travail de médiation avec les maîtres d’ouvrage. Mais on ne peut en aucun cas parler d’une robotisation du métier.

Quant à Markus Braach, il a lancé sa firme Adaptive Architecture qui, comme son nom l’indique, cherche des solutions adaptées aux désirs de ses clients, par algorithmes interposés. Ils proposent par exemple des solutions automatisées d’aménagements de halles de congrès ou de bureaux, qui ne sont pas sans rappeler « l’organisation cybernétique » des années 19605 : en demandant aux utilisateurs de définir leurs besoins, les circulations, les types d’activités, de fixer en somme les paramètres du problème, l’algorithme peut générer des solutions-types d’environnement de travail.

Depuis quelques années à peine, l’intelligence artificielle est capable d’apprendre d’elle-même à partir de quelques données de base, le deep language. Une telle machine, selon Philipp Dohmen, est capable de reconnaître la structure d’un document et commence à être utilisée dans de gigantesques projets de planification, où la somme de documents, de protocoles, de règlements et de normes est tellement importante que plus personne, au sein des équipes pluridisciplinaires, n’est capable d’avoir une vue d’ensemble. L’intelligence artificielle peut être utilisée pour faire le tri parmi les exigences nombreuses et souvent contradictoires en matière d’énergie, de durabilité, de confort, d’économie, etc. Elle continuera donc à évoluer comme un soutien pour nous aider à décider dans des situations de grande complexité. Mais elle ne prendra jamais de décision elle-même.

Cette histoire ne doit pas nous faire seulement réfléchir sur l’angoisse récurrente d’être remplacé par la machine, mais aussi sur la propension à se conforter dans des automatismes de la pensée qui sont partagés aussi bien par les machines que par les hommes. Si l’architecte est réduit à un travail d’optimisation, s’il se contente de puiser dans des répertoires typologiques, de traiter les façades comme une résultante, sans réfléchir à la signification de ses projets, alors oui, les architectes-automates risquent bien de gagner également à ce jeu.

Notes

1 Markus Braach, Oliver Fritz, Benjamin Dillenburger, Alexander Lehnerer, Steffen Lemmerzahl, « Vollautomaten = An Automaton for Making Architecture », Jenseits des Rasters – Architektur und Informationstechnologie = Beyond the Grid – Architecture and Information Technology. Basel/Boston/Berlin, Birkhäuser, ETH Zürich CAAD, 2010, pp. 232-237.

2 Le test de Turing est le test d’intelligence artificielle inventé par Alan Turing (1912-1954). Une machine pourra le passer, avait proposé le mathématicien, quand un interlocuteur sera incapable de déterminer si le langage qu’elle produit est de nature humaine ou artificielle. (Lire l’article p. 17)

3 L’art de casser judicieusement les problèmes initie l’utilisation de l’informatique dans les processus de conception, notamment avec Christopher Alexander au début des années 1960. Entre ses Notes on the Synthesis of Form (1964) et A Pattern Language (1977), l’architecte informaticien passait d’une description des problèmes en arbre, strictement hiérarchisée, à une décomposition en « patterns » que les usagers pourraient organiser collectivement. Certains pensent que le pattern est une des influences du wiki que nous utilisons aujourd’hui pour organiser des réseaux complexes impliquant différents utilisateurs. Voir Molly Wright Steenson, Architectural Intelligence – How Designers and Architects Created the Digital Landscape, Cambridge MA, MIT Press, 2017.

4 Pia Fricker, Ludger Hovestadt, Markus Braach, Benjamin Dillenburger, Philipp Dohmen, Kai Rüdenauer, Steffen Lemmerzahl et Alexander Lehnerer. « Organised Complexity. » Predicting the Future : 25th eCAADe Conference Proceedings, 695-701. eCAADe : Conferences. Frankfurt am Main : Faculty of Architecture and Civil engineering, FH Wiesbaden, 2007.

5 Sur « l’organisation cybernétique » et les Bürolandschaften du Team Quickborn, voir Andreas Rumpfhuber, The Schnelle brothers’ affirmative experiment : « Buch und Ton » office landscape in Gütersloh 1960/61. Ákos Morávanszky und Kirchengast Albert, Experiments : Architektur zwischen Wissenschaft und Kunst. Theoriebau 2, Jovis, 2011.