La cartographie en quatre dimensions

Propos recueillis par Marc Frochaux

Les big data au service de l’histoire? Dans toute l’Europe se constituent des «machines à remonter le temps», des systèmes d’information capables d’exploiter toutes les données connues à ce jour pour créer une nouvelle forme de cartographie qui inclurait la dimension temporelle. L’enjeu, selon Frédéric Kaplan, l’initiateur à l’EPFL de la Venice Time Machine, est immense: il s’agit de réparer la continuité entre un passé méconnu et un présent hypertrophié, saturé d’informations.

TRACÉS : Comment a démarré le projet consistant à créer une «machine à remonter le temps» pour la ville de Venise?

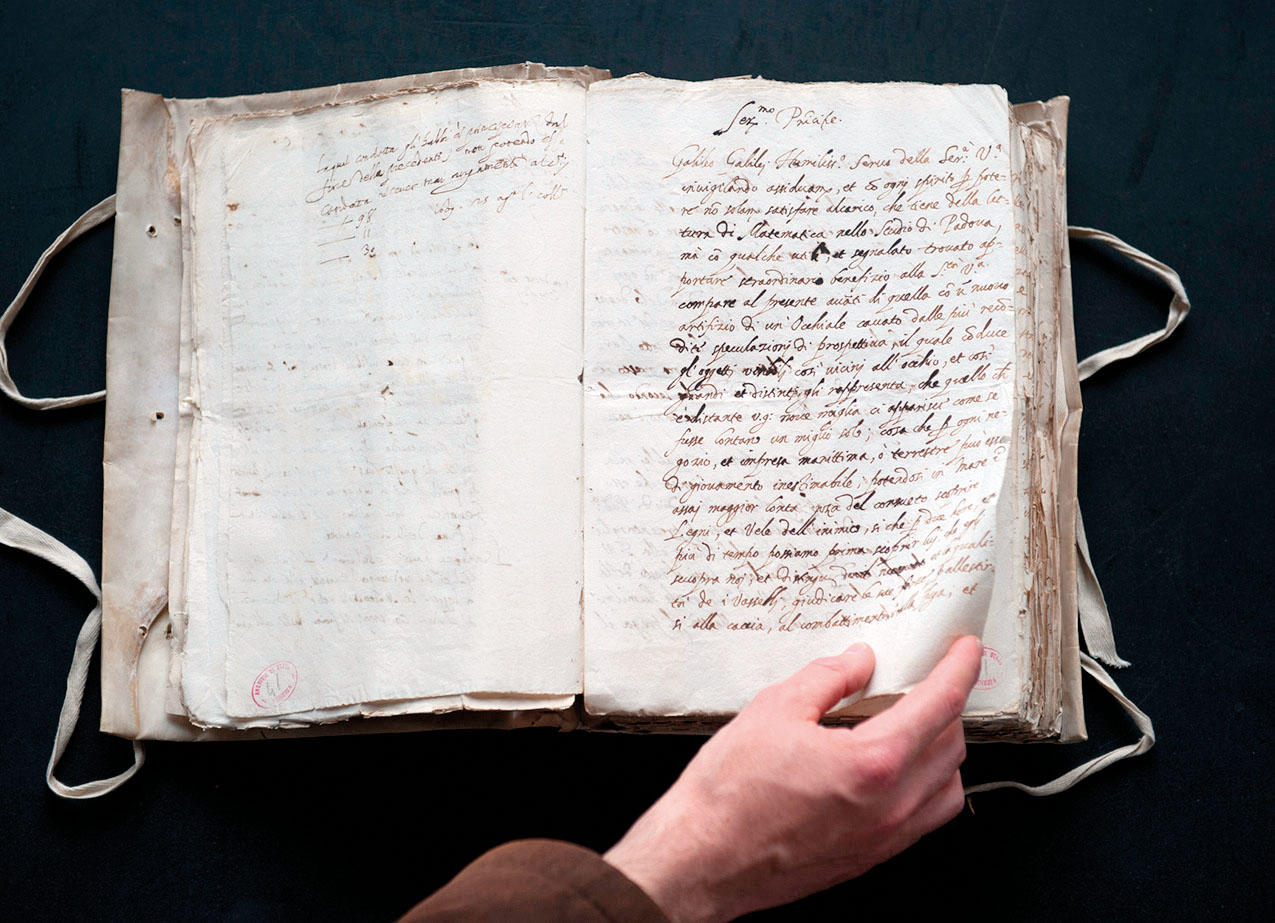

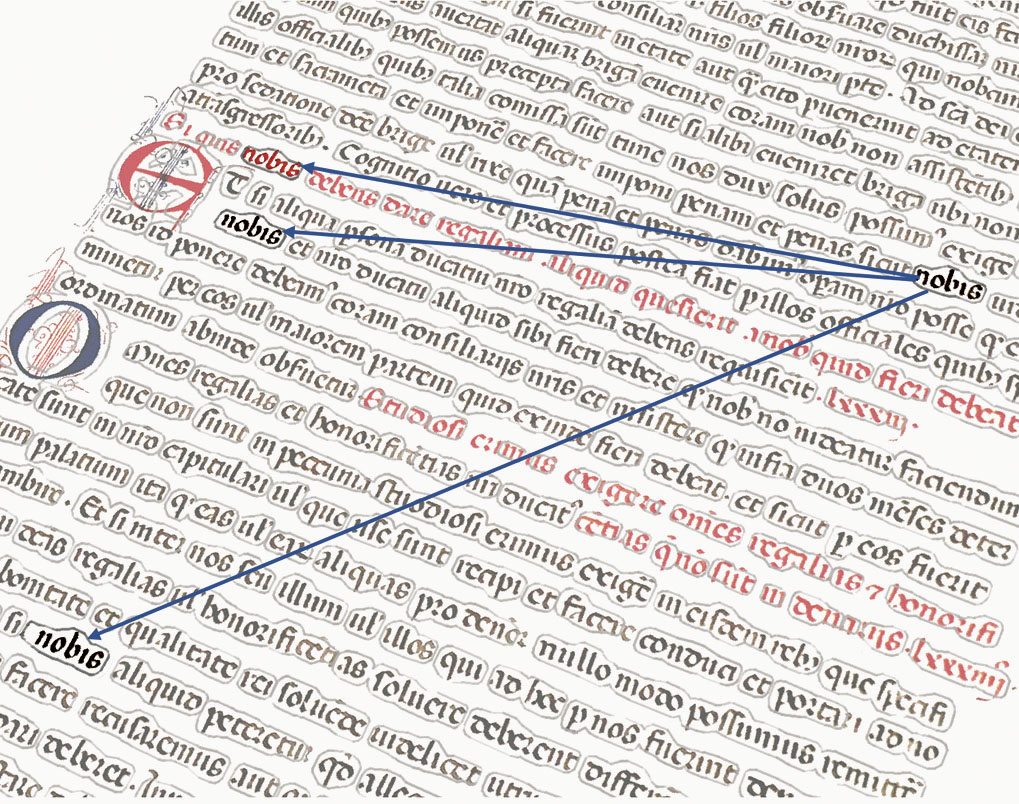

Frédéric Kaplan : Tout a commencé avec la visite des archives d’Etat de Venise qui réunissent une centaine de kilomètres linéaires de documents couvrant plus de mille ans d’histoire. La découverte de cette exceptionnelle densité informationnelle a été un émerveillement, immédiatement accompagné du sentiment déprimant que les centaines d’historiens qui travaillent régulièrement ces données, malgré tout leur talent et leur patience, ne pourront jamais les aborder que très partiellement. C’est un territoire inexploré : la très grande majorité de ces documents n’a jamais été étudiée. Nous avons proposé de les traiter avec les technologies de l’information et, après cinq années de travail, nous avons brisé certains préjugés, démontré qu’il était possible de déchiffrer avec une grande performance les textes anciens. Actuellement, nous atteignons 3 % d’erreurs par caractère et bientôt les ouvrages pourront être numérisés sans même être ouverts, grâce aux méthodes de numérisation tomographique. Chaque mot peut désormais être indexé, ce qui permet de sortir des éléments de cette immense botte de foin en effectuant des recherches par mots-clés – comme sur Google. Il est possible d’indexer les textes, mais aussi les images, et donc de croiser les différentes données : registres, sources littéraires, cartes, peintures, etc.

En quoi cette gigantesque base de données pourra-t-elle intéresser les chercheurs en architecture et en urbanisme ? Sera-t-il possible de reconstituer des bâtiments, voire des quartiers entiers?

La Venice Time Machine (VTM) rend le passé de la ville de Venise accessible, dans un même langage visuel que celui du temps présent. Avec cet outil, toutes les décisions portant sur un morceau de ville pourront être motivées par une connaissance immédiate, intuitive, de l’ensemble des données liées à chaque parcelle.

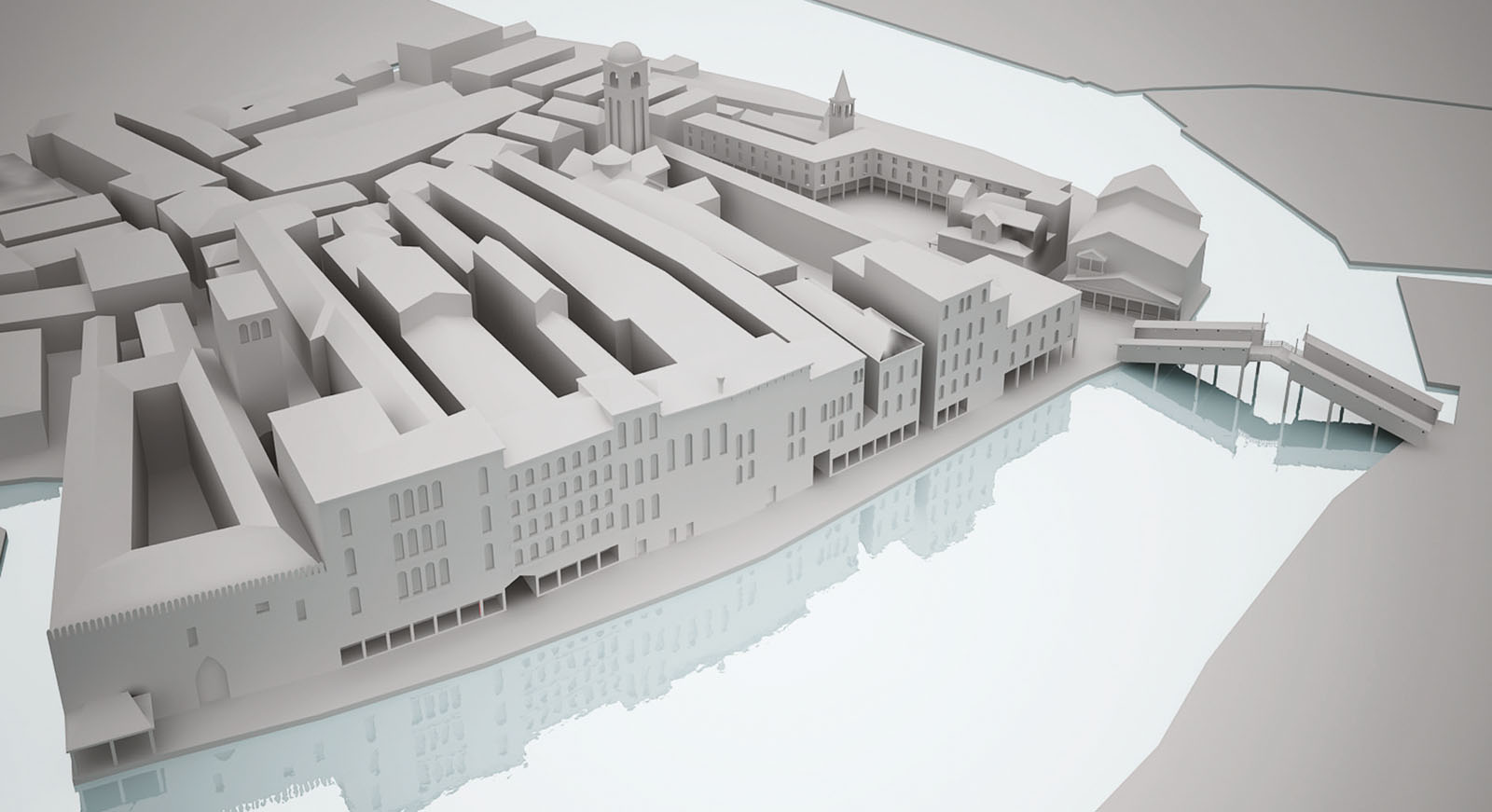

C’est peut-être aussi un débouché professionnel en devenir : les architectes, formés à projeter dans l’avenir, vont contribuer à reconstruire les villes au passé. Et leurs compétences sont indispensables. La reconstitution virtuelle de la Genève de 1850 à partir du relief Magnin1 en est un excellent aperçu : ce modèle a été conçu en partie par des mesures et en partie de manière générative.

La particularité de la VTM est d’associer l’information à l’espace. Pourriez-vous expliquer comment cela fonctionne?

La VTM se compose de trois modules. Il y a d’abord un graphe de connaissance, obtenu par numérisation : c’est le monde du texte, de la linguistique logique. On y trouve un savoir factuel, explicite : l’adresse d’un individu, son contrat d’apprentissage, sa fiche d’impôts, etc.

Or, ce module n’est pas suffisant, il doit être associé à des simulateurs qui vont mettre en mouvement ce passé. Il y a d’abord une « machine à inférence », qui établit des liens (par exemple de parenté) et relève des contradictions parmi les millions de données. Ceci n’existe pas en histoire aujourd’hui. Nous avons ainsi découvert des milliers d’attributions conflictuelles sur des tableaux, dont personne n’avait jusqu’à présent conscience…

Ensuite, il y a le module d’analyse des représentations. La machine apprend à comparer des formes (visuelles pour l’instant) en utilisant des méthodes issues du deep learning. Le module peut par exemple reconnaître deux façades qui se ressemblent, sans avoir l’explication factuelle de leur similarité, sans connaître la grammaire sous-jacente. Nous pouvons également chercher parmi des milliers de tableaux, de gravures, de photographies qui représentent la même vue. Dans le contexte de la VTM, le but est de travailler non pas sur les techniques ou les artistes, mais sur la continuité de la ville au travers de ses représentations. La machine est ainsi capable de situer géographiquement des vues sur la carte et contribue à sa reconstitution.

Le monde des formes aurait-il donc sa propre logique?

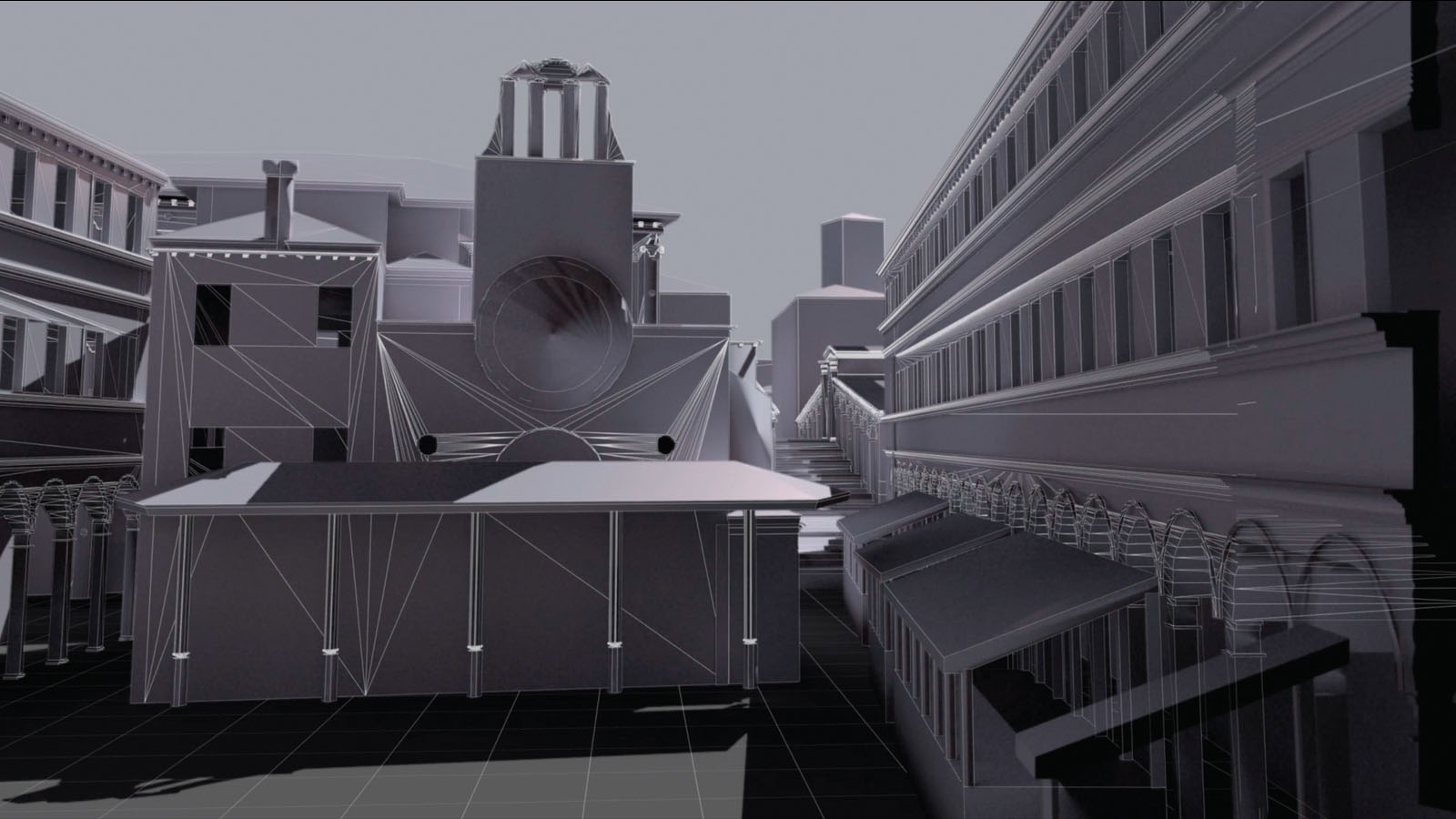

Oui, à côté du graphe du savoir explicite, du système linguistique, il y a un monde des formes, un espace morphologique des formes culturelles, qui est un univers en soi. En cherchant des églises de Palladio, même si l’algorithme ne connaît rien de l’architecte, nous découvrons toutes les architectures qui s’en approchent, et pouvons ainsi apprécier comment ses façades marquent la structure de l’espace. Ce type d’approche est encore plus puissant pour l’«architecture mineure», car il s’agit ici de reconstituer véritablement la «texture» de la ville, sans pour autant connaître explicitement les règles implicites qui régissent ces formes architecturales.

Mais comment ces données sont-elles liées entre elles?

Pour ceci, il y a un troisième module, un simulateur basé sur une grille spatio-temporelle, sur laquelle nous positionnons toutes les données. L’espace-temps a sa propre logique et il est possible de recomposer des situations pour lesquelles les données sont manquantes. Pour une rue du quartier du Rialto, nous pouvons avoir une connaissance explicite comme la liste des commerces figurant dans un registre foncier de 1740, des représentations visuelles, comme des tableaux de Canaletto, datant de quelques années plus tard et des informations sur la structure urbaine précise venant d’un cadastre du début du 19e siècle. La grille spatio-temporelle replace toutes ces données dans un seul référentiel et permet d’observer des patterns, des schémas récurrents, à grande échelle, puis de proposer des hypothèses de continuité. Plus large sera la couverture spatio-temporelle, plus dense pourront être les simulations. En replaçant les données fragmentées du passé dans une seule grille, nous assistons à un profond changement qualitatif : l’émergence du passé comme une trame continue, en perpétuelle renégociation.

Vous comptez produire des représentations basées sur des hypothèses générées par deep learning. N’est-il pas risqué de confier à la machine une telle responsabilité? Va-t-elle nous informer quand elle fait des erreurs ou quand elle émet des hypothèses peu fiables?

De nombreux historiens jugent trop risqué de proposer des représentations d’un passé qui n’est pas totalement documenté. Ils ne représentent pas l’incertain et restent dans les zones bien «éclairées». Or, l’enjeu de la VTM est précisément de représenter aussi les zones moins balisées, et non pas seulement les lieux et les moments riches en information – sur lesquels se concentre habituellement la recherche.

Pour obtenir cette vue d’ensemble, qui inclut les zones d’ignorance, il nous faut trouver un mode de visualisation qui permette la représentation des incertitudes. Dans les zones où nous n’avons pas de documentations visuelles, nous présentons des volumes abstraits, corrects à l’échelle urbaine, mais non détaillés à l’échelle architecturale. Le but est de visualiser le territoire spatio-temporel comme un lieu de débat que les chercheurs pourront contribuer à préciser. Ainsi, nous croyons qu’il est possible de proposer des représentations du passé, mais à condition qu’elles soient toujours en négociation. Cette année à la Biennale de Venise, nous allons montrer un modèle complet de l’évolution de la ville développé par Isabella di Lenardo et son équipe à partir de sources historiques du projet. C’est la première fois que le pavillon de la ville présentera une représentation complète de sa propre histoire. C’est une invitation à enfin étudier la ville comme un objet spatio-temporel intégré.

La VTM a été décrite comme un «réseau social» mis à disposition des historiens, une sorte de Facebook du passé. Cette approche pourrait par exemple nourrir une histoire du quotidien, sociale, «par le bas». Mais en reproduisant la complexité du quotidien, ne craignez-vous pas de noyer les historiens dans l’information, de reproduire une complexité qui empêche la synthèse – un peu comme la carte de Borgès qui prend autant de place que le territoire qu’elle documente?

Avec les technologies de l’information, on peut et on doit faire des cartes qui prennent plus de place que le territoire ! Ce qu’il est important de comprendre, c’est la non-uniformité des connaissances qui subsiste sur un territoire : certaines zones sont très denses en informations, d’autres sont pratiquement vides. Notre travail sur Venise doit montrer cette hétérogénéité en déployant les systèmes d’information sur la ville. Le travail de l’historien ne se situera plus du tout dans la reconstitution, dans la recherche d’une trouvaille (un peu comme un archéologue qui publie une source). En revanche, sa recherche d’explications causales, de liens, de corrélations, son travail interprétatif, vont s’intensifier. Dans la VTM, la causalité est complètement absente. Le savoir-faire de l’historien n’est donc même pas entamé. Au contraire, nous dotons les historiens d’un pouvoir incroyable, avec lequel ils pourront tester leurs hypothèses, contredire les précédentes, etc.

Ne craignez-vous pas les effets pervers d’un trop grand accès au savoir, que tout un chacun puisse s’improviser historien, produire de fausses hypothèses ou nuire à la qualité des études en produisant trop de savoir? C’est ce qui s’est passé dans le journalisme depuis que la production de l’information a été «démocratisée»…

En effet, l’effet secondaire sera l’entrée en scène de non-historiens qui construiront du discours historique sans en avoir les compétences universitaires. Et cela peut produire de l’information de moins bonne qualité. C’est un débat perpétuel qui a d’ailleurs déjà eu lieu avec l’introduction de l’imprimerie, quand les non-érudits ont eu accès aux livres. Cela provoque des contestations évidentes sur la maîtrise du savoir. Mais il n’y a pas de doute qu’à moyen terme l’accès à la connaissance est toujours bénéfique, même si cela se paie par une plus large production amateure. Le territoire du passé est immense, nous avons besoin de millions d’explorateurs.

En quoi l’histoire peut-elle intéresser à ce point l’avenir de l’Europe? Le concept de Time Machine peut-il être étendu?

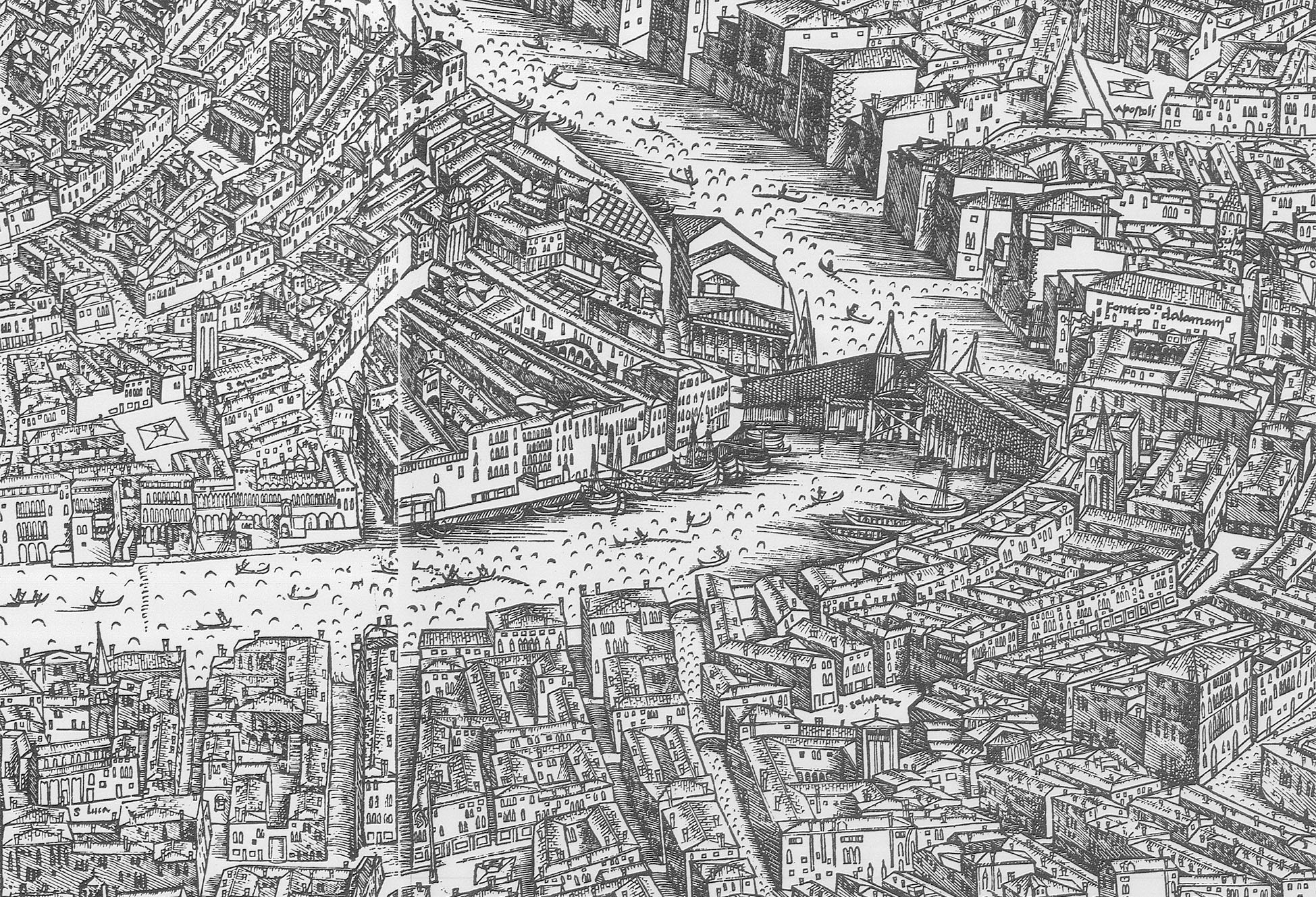

La VTM sert de preuve de concept pour un projet scientifique de grande ampleur qui concourt actuellement pour devenir l’une des Initiatives phares des Technologies Emergentes (FET Flagship), comme le Human Brain Project 2. Actuellement, le projet réunit 170 partenaires académiques, répartis dans 32 pays. Notre but est de créer une time machine à l’échelle européenne. Plusieurs villes importantes, comme Amsterdam, Nuremberg, Paris, Budapest ou Jérusalem ont déjà entamé ce travail. Il s’agit de transformer les milliers de kilomètres d’archives et de collections muséales de toute l’Europe en un système d’information digitale. L’enjeu est énorme : nous voulons étendre le domaine des big data au passé (%%gallerylink:31871:figure%%) et mettre tout ce savoir en accès libre afin de doter l’Europe d’un patrimoine technologique lui permettant d’exploiter de manière indépendante ses données.

Un milliard pour l’histoire? Croyez-vous vraiment que l’archivistique peut bénéficier d’un financement de recherche européen de cette ampleur?

Il y a encore quelques années, il semblait farfelu d’interroger le passé à la même échelle que d’autres domaines, comme la médecine par exemple. Or, si nous démontrons l’importance de ce territoire, nous serons non seulement les pionniers, mais aussi les défenseurs d’un patrimoine immense. Deux continents sont en train de se séparer : la densité extrême du présent, d’un côté, et l’absence d’information sur le passé. Nous aimerions retrouver ce continuum entre les données passées et présentes, établir une traduction continue des textes anciens jusqu’à ceux d’aujourd’hui. Aujourd’hui, les big data alimentent un «grand présent»3. Tout a grandi si vite que le temps n’a pas été pris en compte. Mais dans cinquante ans, il y aura plus de morts sur Facebook que de vivants… A partir de là, de fait, Facebook sera l’archive. Souhaitons-nous cela ? L’entreprise de Zuckerberg le souhaite-t-elle elle-même?

Il y a un enjeu immense à prendre la responsabilité de cette mémoire et à remettre le présent dans une dimension temporelle. Nous devons conquérir notre indépendance vis-à-vis de très grands groupes privés, empêcher que l’accès au passé et les méthodologies qui gèrent cet accès soient contrôlés. La maîtrise des big data du passé est un enjeu majeur. Il est urgent qu’ils rentrent dans le domaine public et cette opération doit faire l’objet d’un financement public.

Frédéric Kaplan est ingénieur en intelligence artificielle, il est professeur titulaire de la chaire d’humanités digitales à l’EPFL.

Notes

1 En 1896, après 18 ans de travaux sous la direction de l’architecte Auguste Magnin, une équipe d’orfèvres a pu achever une maquette en métal de 30 m2 qui montre la ville encore enserrée dans ses trois rangs de fortification. En 2011, constatant sa grande précision géométrique, un modèle 3D texturé et parfaitement calé sur le cadastre officiel a pu être réalisé : www.geneve1850.ch

2 FET Flagships («Initiatives-phare des Technologies Futures et Emergentes» en français) est une initiative de la Commission européenne dans le contexte des Programmes-cadre pour la recherche et le développement technologique de l’Union européenne. Elle met au concours un soutien financier d’un milliard d’euros répartis sur dix ans. Le Human Brain Project, piloté par l’EPFL, en bénéficie depuis 2013. Suite à la soumission déposée en 2016 auprès de la Commission européenne, le Time Machine FET Flagship vise à créer un simulateur à grande échelle pour cartographier 2000 ans d’histoire européenne avec la participation d’environ 200 institutions réparties dans toute l’Europe.

3 Sur la critique du «grand présent», voir le récent essai de Jérôme Baschet, Défaire la tyrannie du présent (La Découverte, 2018).